Правильно настраиваем robots.txt на ucoz | |

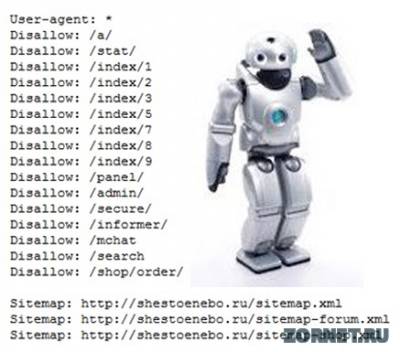

| В интернете, нашел много ГЕНЕРАТОР ФАЙЛОВ ROBOTS.TXT что могу сказать о них. Да некоторые выдают robots.txt, но он не полный. Мой совет не доверять таким онлайн сервисом. Так как это главная часть индексация сайта. Как пропишите его, так и будит индексировать ваш сайт. Не которые так прописывают что robots.txt не пускают поисковых ботов чтоб индексировали сайт. Мне на многих блогах и сайтов у которых тематика CEO. Скажу сразу а не обращаюсь на сайты ucoz за такими консультациями. В 99% вам там наобещают все исправить за ваши деньги. А будут исправлять и составлять школьники у которых шапочное знание и у них одна цель только деньги. Чайки епть, больше не могу их назвать. И вот мне посоветовали с robots.txt убрать этот раздел. Код Disallow: /index/6 Как мне объяснили он там совсем не нужен. Не которые на сайтах ucoz сне вообще предлагали убрать robots.txt. Да есть такие умника, как описал выше. Спросите что будит если убрать, или у каго нет robots.txt. Ну первым скажу у каго нет robots. Вы скажите в поиске много страниц, но вы посмотрите внимательно поисковые ссылки. Там больше хлама поискового. Это к примеру пользователи, их персональная страница и данные. И скажу оно вам надо. Кто пойдет по такой поисковый ссылке. Так как не имения файла robots боты поисковые копируют в поиск что первое попадется и чтоб была немного уникальное. А персональные страницы скажем они все уникальные, так как нет не одной похоже. Что я хотел этой статьей сказать? Файл robots.txt он нужен на сайте, но настроен должен быть под ваш сайт. Как мне сказали на системе uCoz головника не надо поставить стандартный robots и не каких проблем. Вот так выглядит стандартный robots.txt взят с официального сайта ucoz Код User-agent: *Disallow: /a/ Disallow: /stat/ Disallow: /index/1 Disallow: /index/2 Disallow: /index/3 Disallow: /index/5 Disallow: /index/7 Disallow: /index/8 Disallow: /index/9 Disallow: /panel/ Disallow: /admin/ Disallow: /secure/ Disallow: /informer/ Disallow: /mchat Disallow: /search Disallow: /shop/order/ Disallow: /?ssid= Sitemap: http://сайт/sitemap.xml Sitemap: http://сайт/sitemap-forum.xml Sitemap: http://сайт/sitemap-shop.xml Но если у вас куплен домен, вам нужно прописать его в файле. Код Host: zornet.ru Чтоб не было зеркало. Просто замените на свой сайт. Будит выглядеть так: Код User-agent: *Disallow: /a/ Disallow: /stat/ Disallow: /index/1 Disallow: /index/2 Disallow: /index/3 Disallow: /index/5 Disallow: /index/7 Disallow: /index/8 Disallow: /index/9 Disallow: /panel/ Disallow: /admin/ Disallow: /secure/ Disallow: /informer/ Disallow: /mchat Disallow: /search Disallow: /shop/order/ Disallow: /?ssid= Host: zornet.ru Sitemap: http://сайт/sitemap.xml Sitemap: http://сайт/sitemap-forum.xml Sitemap: http://сайт/sitemap-shop.xml Но вот как то так. Хлам в поиск пускать не будит, всем поисковым ботом разрешается зайти на ваш сайт и искать что то новое. Первое что они ищут ссылки новые потом описание. Думаю понятно объяснил, если делаете оптимизацию сайта, мой совет спросите, будит ли изменение в файле robots.txt. Если чел ответит, что он и так настроен хорошо. Я бы такому человеку не доверил. Так как делается оптимизация сайта "Внутренне" Все равно связано с файлом.

Вот таким образом мы запрещаем поисковым системам читать наши «sekretiki» (сам директория и адреса начинающие на нее под запретом): Код User-agent: * Disallow: /sekretiki/ Спецсимволы и комментарии: Для того, чтобы запретить только сам раздела без его содержимого, на конце ставится знак $: Код User-agent: * Disallow: /sekretiki$ Таким образом, дирректория «/sekretiki» запрещены к индексации, но «/sekretiki.html» допустимы. Для использования в адресе переменные, используйте звездочки: Код User-agent: * Disallow: /sekretiki/*-0-0 Disallow: /news/17-*-0-* С помощью этих символов, можно сделать правило на запрет индексирования страниц дублей: Код Disallow: /*&* Код можно комментировать. Все что находится после # в строке не читается: Код User-agent: * # Приветствую всех роботов Allow: /sekretiki/ # Разрешаю секретики Disallow: / # Запрещаю индексировать все остальные страницы User-agent: GoogleBot # Приветствую только робота Google Disallow: /sekretiki/ # А вот ему я запрещаю именно секретики Указываем карту сайта Sitemap: Если не указать ссылку на карту сайта, то робот не сможет быстро индексировать сайт, новые страницы без sitemap.xml могут не попасть в индекс даже в течении нескольких месяцев. uCoz сам генерирует карту сайта, в том числе и отдельную для форума, поэтому в конце robots.txt указаны такие строки: Код Sitemap: http://forum.ucoz.ru/sitemap.xml Sitemap: http://forum.ucoz.ru/sitemap-forum.xml Существуют и другой момент в robots.txt, называется Clean-param. Он позволит указать неиспользуемые параметры, не влияющие на содержимое страницы, чтобы робот не заходил на них лишний раз. В uCoz такой тонкой необходимости нет, мы сразу убираем дубли без указания конкретных параметров. Если вы обнаружили, что на вашем сайте испорчен файл robots.txt, просто удалите его, при запросе система сама подставит правильный robots.txt. Это относится именно к специфики работы с uCoz. Разбор стандартного robots.txt uCoz: Теперь, когда вы знаете, из чего состоит файл robots.txt, перейдем к расшифровке стандартного:

| |

Поделиться в социальных сетях

Материал разместил

| Комментарии: 9 | |

|

| |